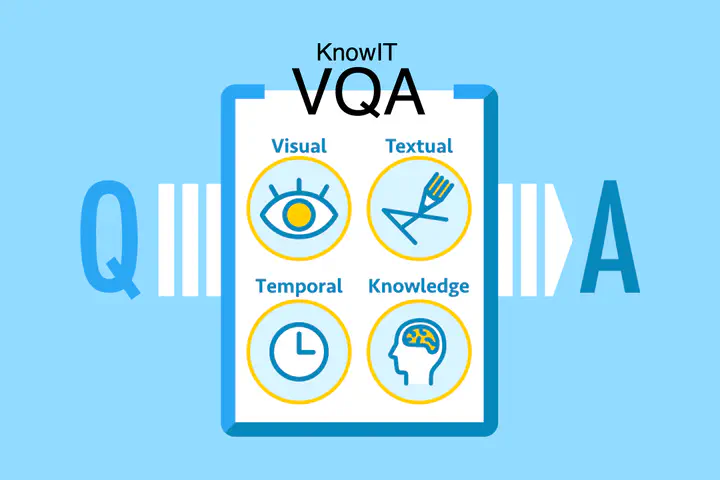

Knowledge VQA

知識を要する画像・映像に関する質疑応答(Knowledge Visual Question Answering; KVQA)は、画像・映像に関する質問で、回答に知識を必要とするタスクです。知識を要求するこの新しいタスクは、今までのタスクと同様画像・映像の理解に加えて、どうやって知識を収集するのか、回答生成時にどうやって(外部)知識を取り入れるのか、という新しいチャレンジが必要になります。

このプロジェクトでは、KVQAのための新しいデータセットを構築し、公開しています。この成果は、人工知能分野のトップカンファレンスの一つであるAAAI 2020で発表しました。

また、深層学習などでの利用にあたって映像をどのように表現するかは、質疑応答をはじめとする様々なタスクにおいて主要な研究課題となっています。特に、視覚と自然言語を入力とするタスクでは、モデルが自然言語ばかり注目するような現象もあるようで、難しい問題です。このプロジェクトでは、映像をテキストで表現するアプローチ(キャプション生成のような教師ありの手法ではなく、映像から必要なオブジェクトなどを検出してルールベースでテキストを生成する手法)を採用し、既存手法と比較しています。この成果は、コンピュータビジョン分野のトップカンファレンスの一つであるECCV 2020で発表しました。

関連した研究として、絵画に関するQAについても取り組んでいます。

Publications

- Noa Garcia, Chentao Ye, Zihua Liu, Qingtao Hu, Mayu Otani, Chenhui Chu, Yuta Nakashima, and Teruko Mitamura (2020). A Dataset and Baselines for Visual Question Answering on Art. Proc. European Computer Vision Conference Workshops.

- Noa Garcia and Yuta Nakashima (2020). Knowledge-Based VideoQA with Unsupervised Scene Descriptions. Proc. European Conference on Computer Vision.

- Noa Garcia, Mayu Otani, Chenhui Chu, and Yuta Nakashima (2020). KnowIT VQA: Answering knowledge-based questions about videos. Proc. AAAI Conference on Artificial Intelligence.

- Zekun Yang, Noa Garcia, Chenhui Chu, Mayu Otani, Yuta Nakashima, and Haruo Takemura (2020). BERT representations for video question answering. Proc. IEEE Winter Conference on Applications of Computer Vision.

- Noa Garcia, Chenhui Chu, Mayu Otani, and Yuta Nakashima (2019). Video meets knowledge in visual question answering. MIRU.

- Zekun Yang, Noa Garcia, Chenhui Chu, Mayu Otani, Yuta Nakashima, and Haruo Takemura (2019). Video question answering with BERT. MIRU.